Welcome to gwimong's Blog!

안녕하세요. 귀몽이의 개인 블로그입니다.-

EC2 Instance Connect를 활용한 파일 전송

개요

EC2 Instance Connect를 활용한 파일 전송 방법입니다.

.pem키 파일 관리 없이 임시 공개키를 주입하여 SCP로 파일을 전송합니다. 유효기간은 60초입니다.EC2 접속은 이전 글을 참고합니다.

전제 조건

EC2 인스턴스

- EC2 Instance Connect 지원 AMI (Amazon Linux 2/2023, Ubuntu LTS)

- 보안 그룹 인바운드 22/TCP 허용

IAM 권한

ec2-instance-connect:SendSSHPublicKeyec2:DescribeInstances

도구

- AWS CLI v2 설치

- 조직 계정은 AWS SSO 로그인 필요

접속 계정

- Amazon Linux / RHEL:

ec2-user - Ubuntu:

ubuntu

키 생성

최초 1회만 실행합니다.

ssh-keygen -t ed25519 -f ~/.ssh/id_ed25519 -N ""공개키:

~/.ssh/id_ed25519.pub개인키:~/.ssh/id_ed25519인스턴스 AZ 확인

aws ec2 describe-instances --instance-ids <INSTANCE_ID> \ --query "Reservations[0].Instances[0].Placement.AvailabilityZone" \ --region ap-northeast-2 --profile <SSO_PROFILE>예:

ap-northeast-2a임시 공개키 주입

유효기간 60초로 공개키를 주입합니다.

aws ec2-instance-connect send-ssh-public-key \ --instance-id <INSTANCE_ID> \ --availability-zone <AZ> \ --instance-os-user <ubuntu|ec2-user> \ --ssh-public-key file://~/.ssh/id_ed25519.pub \ --region ap-northeast-2 --profile <SSO_PROFILE>파일 전송

업로드

scp -i ~/.ssh/id_ed25519 ./localfile ubuntu@<PUBLIC_IP>:~/다운로드

scp -i ~/.ssh/id_ed25519 ubuntu@<PUBLIC_IP>:~/logs/app.log ./app.log디렉토리

scp -r -i ~/.ssh/id_ed25519 ./local_dir ubuntu@<PUBLIC_IP>:~/remote_dir프라이빗 인스턴스

배스천 호스트 경유:

scp -i ~/.ssh/id_ed25519 -o ProxyJump=ubuntu@<BASTION_IP> \ ./localfile ubuntu@<PRIVATE_IP>:~/자동화

#!/bin/bash INSTANCE_ID="i-xxxxxxxxx" AZ="ap-northeast-2a" TARGET_IP="x.x.x.x" aws ec2-instance-connect send-ssh-public-key \ --instance-id $INSTANCE_ID \ --availability-zone $AZ \ --instance-os-user ubuntu \ --ssh-public-key file://~/.ssh/id_ed25519.pub \ --region ap-northeast-2 scp -i ~/.ssh/id_ed25519 $1 ubuntu@$TARGET_IP:~/큰 파일 전송 시 60초 제한에 주의합니다. 공개키 주입과 SCP를 연속 실행하는 스크립트로 만듭니다.

보안

임시 키는 60초 후 자동 무효화됩니다.

모든 접속 시도가 CloudTrail에 기록됩니다.

빈번한 파일 전송이 필요하면 SSM Session Manager 사용을 검토합니다.

참고

-

EC2 인스턴스 접속 방법

개요

AWS EC2 인스턴스에 접속하는 방법을 정리하였습니다.

사전 요구사항

- EC2 인스턴스가 실행 중이어야 합니다.

- 보안 그룹에서 SSH(22번 포트) 또는 SSM 접근이 허용되어야 합니다.

mssh

AWS SSO/IAM 인증 기반 접속 방식입니다.

키 파일 관리가 필요 없으며, 조직 단위 권한 관리가 가능합니다.설치

세 가지를 설치해야 합니다.

AWS CLI v2

- https://docs.aws.amazon.com/cli/latest/userguide/getting-started-install.html

aws --versionSession Manager Plugin

- https://docs.aws.amazon.com/systems-manager/latest/userguide/session-manager-working-with-install-plugin.html

session-manager-plugin --versionEC2 Instance Connect CLI

pip install ec2instanceconnectcli mssh --version접속

# SSO 로그인 aws sso login --profile <SSO_PROFILE> # 인스턴스 접속 mssh i-0fe6de40241a44021 --region ap-northeast-2 --profile <SSO_PROFILE>region과 profile은 생략 가능하지만 명시하는 것을 권장합니다.

OpenSSH

EC2 생성 시 발급받은 키 페어(.pem)를 사용합니다.

Linux/macOS는 기본 설치, Windows 10 이상에서도 사용 가능합니다.접속

ssh -i my-key.pem ec2-user@<PUBLIC_IP>- Ubuntu: ubuntu

- Amazon Linux: ec2-user

권한 에러 발생 시

chmod 600 my-key.pem

PuTTY

Windows용 SSH 클라이언트입니다.

Windows 10 이상은 OpenSSH를 기본 제공하므로 PuTTY가 필수는 아닙니다.

키 변환

PuTTY는 .pem을 직접 사용할 수 없어 .ppk로 변환이 필요합니다.

PuTTYgen 사용

- Load 버튼으로 .pem 파일 선택

- Save private key로 .ppk 저장

접속

- PuTTY 실행

- Host Name: ec2-user@<PUBLIC_IP>

- Ubuntu는 ubuntu@<PUBLIC_IP>

- Connection → SSH → Auth에서 .ppk 선택

- Open

웹 콘솔

브라우저만으로 접속 가능합니다.

필요 권한

- ssm:StartSession

- ec2-instance-connect:SendSSHPublicKey

EC2 Instance Connect

EC2 콘솔 → 인스턴스 선택 → Connect → EC2 Instance Connect → Connect

가장 간단한 방법입니다.

Session Manager

EC2 콘솔 → 인스턴스 선택 → Connect → Session Manager → Connect

- SSM Agent 설치 및 IAM Role 필요

- SSH 22번 포트 차단 시에도 접속 가능

Serial Console

네트워크 불통 시에도 접속 가능합니다.

EC2 설정에서 활성화가 필요합니다.

접속 방법 비교

방법 인증 설치 장점 단점 mssh IAM/SSO 필요 키 관리 불필요 설치 복잡 OpenSSH PEM 거의 없음 빠르고 단순 키 관리 필요 PuTTY PPK 필요 GUI 제공 키 변환 필요 웹 콘솔 IAM 없음 즉시 접속 기능 제한적

권장 사항

- 조직 환경: mssh - IAM 기반 권한 관리로 보안성 향상

- 개인 환경: OpenSSH - 빠르고 간단

- 임시 접속: 웹 콘솔 - 설치 없이 즉시 사용

[참고 문서]

- https://docs.aws.amazon.com/cli/latest/userguide/getting-started-install.html

- https://docs.aws.amazon.com/systems-manager/latest/userguide/session-manager-working-with-install-plugin.html

- https://aws.amazon.com/ec2/instance-connect/

-

REST Api 아키텍처

REST

REST(RE Presentational State Transfer)는

Roy Fielding이 2000년에 발표한 논문에 처음 등장한 분산형 하이퍼미디어 시스템의 아키텍처 스타일입니다.CHAPTER 5 : Representational State Transfer (REST)

This chapter introduces and elaborates the Representational State Transfer (REST) architectural style for distributed hypermedia systems, describing the software engineering principles guiding REST and the interaction constraints chosen to retain those principles, while contrasting them to the constraints of other architectural styles. REST is a hybrid style derived from several of the network-based architectural styles described in Chapter 3 and combined with additional constraints that define a uniform connector interface. The software architecture framework of Chapter 1 is used to define the architectural elements of REST and examine sample process, connector, and data views of prototypical architectures.

REST 제약 조건

REST는 몇가지 제약 조건이 있으며, 이 가이드를 준수한 인터페이스를 RESTful하다고 표현합니다.

Client-Server

하이브리드 스타일에 추가된 첫 번째 제약 조건은 Client-Server의 관심사를 분리시키는 것입니다.

사용자 인터페이스 문제와 데이터 저장 등의 문제를 분리함으로써 여러 플랫폼에서 사용자 인터페이스의 이식성을 높이고,

서버 구성 요소를 단순화하여 확장성을 향상시킬 수 있습니다.Stateless

하이브리드 스타일은 HTTP에서 영감을 얻었기 때문에, HTTP의 기본 원칙인 Stateless가 반영되었습니다.

서버는 서비스 요청에 대한 어떤 것도 저장하지 않으며, 클라이언트의 모든 요청에는 해당 요청을 이 해할 수 있는 모든 정보가 포함되어야 합니다.Cache

요청에 대한 응답 내의 데이터에 암시적 또는 명시적으로 캐시 가능/불가능 라벨이 지정 되어야 합니다.

이러한 캐시 사용은 일부 상호 작용을 부분적 또는 완전히 제거하여 평균 대기 시간을 줄여 효율성, 확장성 및 사용자의 인식 성능을 향상 시킬 수 있습니다.

그러나 캐시 내의 오래된 데이터와 서버에 존재하는 데이터가 다를 경우 안정성이 감소 할 수 있습니다.Uniform Interface

REST 아키텍처 스타일의 핵심은 구성 요소 간의 균일한 인터페이스를 강조하는 것입니다.

소프트웨어 엔지니어링의 일반 원칙을 컴포넌트 인터페이스에 적용함으로써 전체 시스템 아키텍처가 단순화되고 가시성이 향상됩니다.

이러한 아키텍처는 서비스와 분리되어 독립적으로 발전 할 수 있으나, 표준화된 형식이 아닌 경우 균일한 인퍼페이스는 오히려 효율성을 저하 시킬 수 있습니다.즉, REST 인터페이스는 대규모 하이퍼미디어 데이터 전송에 효율적으로 설계되어 웹의 일반적인 경우에는 최적의 효율을 낼 수 있지만, 다른 형태의 아키텍처 상호 작용에는 적합하지 않을 수 있습니다.

Layered System

인터넷 규모 요구 사항에 대한 동작을 개선하기 위해 추가 된 제약 조건입니다.

계층형 시스템 스타일은 각 구성 요소가 상호 작용하는 인접 계층을 볼 수 없도록 구성 요소 동작을 제한합니다.

이러한 구조는 각 계층의 독립성을 보장하며 보안, 로드 밸런싱, 암호화 등 여러 계층을 유연성 있게 추가/삭제 할 수 있습니다.Code-On-Demand(Optional)

애플릿이나 스크립트 형식으로 코드를 다운로드하고 이를 실행 할 수 있는 기능을 제공합니다.

이 기능은 시스템에 유연성과 확장성을 제공 할 수 있지만, 가시성을 감소시키므로 선택적인 제약 사항입니다.REST 스타일을 제시한 시점에는 Web은 대부분 정적 document이었으며, 클라이언트에서 비즈니스 로직을 구현하기에는 많은 어려움이 있었습니다.

이러한 환경을 고려하여 Code-On-Demand 기능을 선택적으로나마 제약 조건으로 추가한 것으로 추측 됩니다.

현재에는 보안상 문제로 인해 거의 적용하지 않습니다.

설계 원칙

Restfull한 API를 설계하기 위해 다음의 4가지 원칙을 준수합니다.

자원을 식별 할 수 있어야 한다.

가장 기본적인 원칙으로 URL만으로 어떤 자원을 제어 할 수 있는지 알 수 있어야 합니다.

즉, URL은 특정 자원의 위치 및 종류에 대한 정보를 포함하며 URL만으로 자원을 명확히 식별 할 수 있어야 합니다.행위는 명시적이어야 한다.

자원을 제어하기 위한 행위는 명시적이어야 합니다.

강제된 사항은 아니지만, 일반적으로 HTTP Method으로 표현합니다.- GET : Select

- POST : Create

- PUT : Update

- DELETE : Delete

자기 서술적이어야 한다.

데이터 처리를 위한 모든 정보가 포함 되어야 합니다.

HATEOS

Hypermedia as the Engine of Application Sate.

서버는 하이퍼미디어를 이용하여 애플리케이션 상태 전이를 수행 할 수 있어야 합니다.

설계 규칙

Restfull API를 설계하기 위해 다음의 규칙들을 권장합니다.

- 슬래시 구분자(/)는 계층 관계를 나타내는데 사용합니다.

- Ex) http://restapi.example.com/users/groups

- 리소스는 동사가 아닌 명사를 사용합니다.

- 도큐먼트 이름: 단수 명사

- 컬렉션 이름 : 복수 명사

- 스토어 이름 : 복수 명사

- 경로 중 변하는 부분은 유일한 값으로 대체합니다.

- 리소스 간 연관 관계가 있는 경우(일반적으로 소유 관계를 표현 시) : /[리소스]/{리소스 id}/[다른 리소스]

- Ex) http://restapi.example.com/users/{userid}/children → http://restapi.example.com/users/12/children

- 자원에 대한 행위는 HTTP Method로 표현합니다.

- Ex) GET http://restapi.example.com/users/delete/1 (x)

- Ex) DELETE http://restapi.example.com/users/1 (o)

- Trailing slash(URI의 끝에 붙이스는 슬래시)는 사용하지 않는다.

- 트레일링 슬래시(Trailing slash)는 해당 URL 리소스가 디렉토리(directory)임을 의미하기 위해 사용 되었습니다.

- REST에서 슬래시 구분자는 각 계층의 관계를 나타내는데 사용되고 있으므로, 트레일링 슬래시는 혼동을 줄 수 있습니다.

- Ex) http://restapi.example.com/users/groups/ (x)

- Ex) http://restapi.example.com/users/groups (o)

- 불가피하게 2음절 이상의 리소스를 표현해야 한다면, 하이픈(-)을 사용합니다.

- 밑줄 때문에 문자가 가려지기도 하므로 가독성을 위해 하이픈을 사용합니다.

- Ex) http://restapi.example.com/colors/deep_blue (x)

- Ex) http://restapi.example.com/colors/deep-blue (o)

- URI 경로는 소문자를 사용합니다.

- RFC 3986(URI 문법 형식)은 URI 스키마와 호스트를 제외하고는 대소문자를 구별하도록 규정되어 있습니다.

- 파일 확장자는 URI에 포함하지 않습니다.

- Accept header를 사용합니다.

- Ex) http://restapi.example.com/users/1/photo.jpg(x)

- Ex) http://restapi.example.com/users/1/photo

Accept: image/jpg (o)

[참고 문서]

- https://ics.uci.edu/~fielding/pubs/dissertation/rest_arch_style.htm

- https://restfulapi.net/

-

Gitlab-runner 특정 계정으로 실행하기

오류 내용

Gitlab runner에서 job 실행 시, 설정한 계정이 아닌 root로 실행 되는 경우 발생

환경

gitlab-runner 설치

gitlab-runner 서비스 등록

gitlab-runner를 특정 계정으로 실행하기 위해 service에 등록합니다.

(gitlab-runner install은 gitlab-runner을 설치하는 것이 아닌, 서비스에 등록하기 위한 명령어입니다.)# 계정 생성 $ sudo useradd --create-home uatm --shell /bin/bash # 서비스 생성 $ sudo gitlab-runner install --user=uatm --working-directory=/home/uatm # 서비스 실행 $ sudo gitlab-runner startgitlab-runner 실행

gitlab-runner run은 job을 실행키기 위한 명령어입니다.

명령은 실행되어 신호를 받을 때까지 대기합니다.$ sudo gitlab-runner run.gitlab-ci.yml

Gradle을 이용하여 test와 build를 수행하는 job을 생성합니다.

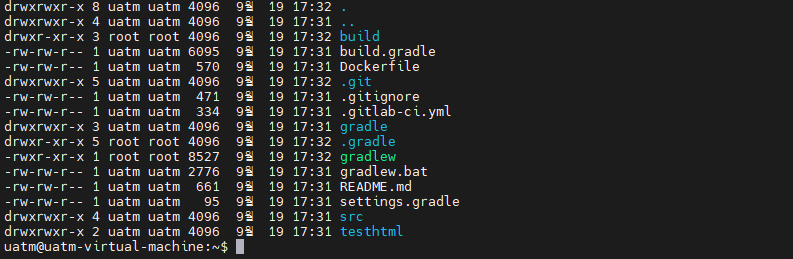

stages: - test - build - deploy cache: paths: - build/ test: stage: test script: - echo 'Testing...' - chmod +x gradlew - ./gradlew test tags: - build build: stage: build script: - echo 'Building...' - chmod +x gradlew - ./gradlew clean - ./gradlew assemble tags: - build현상

일부 디렉토리(build, .gradle) 및 파일(gradlew)의 소유자가 root로 변경되어 있습니다.

2번째로 실행 된, build job에서 실행한 script 명령어가 root의 권한으로 수행된 것입니다.

오류 원인

gitlab-runner의 start와 run 명령을 모두 실행 시켜 발생한 현상입니다.

서비스에 등록된 gitlab-runner가 job 실행시키면 설정된 계정으로 실행되지만,

gitlab-runner의 run 명령어로 생성된 프로세스가 job을 실행하게 되면 root 권한으로 실행 된 것입니다.회고

gitlab-runner의 명령어(run / start / install)를 제대로 이해하지 못하고 사용하다보니 문제 해결에 오랜 시간이 걸렸습니다.

공식 메뉴얼을 좀 더 상세히 읽어야하겠습니다.

-

QueryDSL gradle 설정

QueryDSL?

Querydsl은 JPA, MongoDB 및 Java SQL을 포함한 여러 백엔드에 대해 유형이 안전한 SQL 유사 쿼리를 생성할 수 있는 프레임워크입니다.

쿼리를 인라인 문자열로 작성하거나 XML 파일로 외부화하는 대신 유창한 API를 통해 구성됩니다.

Gradle을 이용한 설정

querydsl 버전 정의

buildscript { ext { queryDslVersion = "5.0.0" } }의존성 설정

dependencies { implementation "com.querydsl:querydsl-jpa:${queryDslVersion}" implementation "com.querydsl:querydsl-apt:${queryDslVersion}" annotationProcessor "com.querydsl:querydsl-apt:${queryDslVersion}" }Gradle plugin(com.ewerk.gradle.plugins.querydsl)을 사용하는 방법도 있으나, 해당 플러그인의 버전과 Intellij의 버전 등의 호환성으로 문제가 발생할 수도 있습니다.

참조 : [gradle] 그레이들 Annotation processor 와 QuerydslQuerydsl 설정

def querydslDir = "$buildDir/generated/querydsl" querydsl { jpa = true querydslSourcesDir = querydslDir } sourceSets { main.java.srcDir querydslDir } configurations { querydsl.extendsFrom compileClasspath } compileQuerydsl { options.annotationProcessorPath = configurations.querydsl }QClass 생성 경로 등을 설정합니다.

Querydsl 빌드

Clean

gradle cleanQuerydslSourcesDirBuild

gradle compileQuerydsl문제 해결

compileQuerydsl 빌드 실패

대부분 버전간 호환성이나 Gradle / IDE 설정이 문제인 경우가 많습니다.

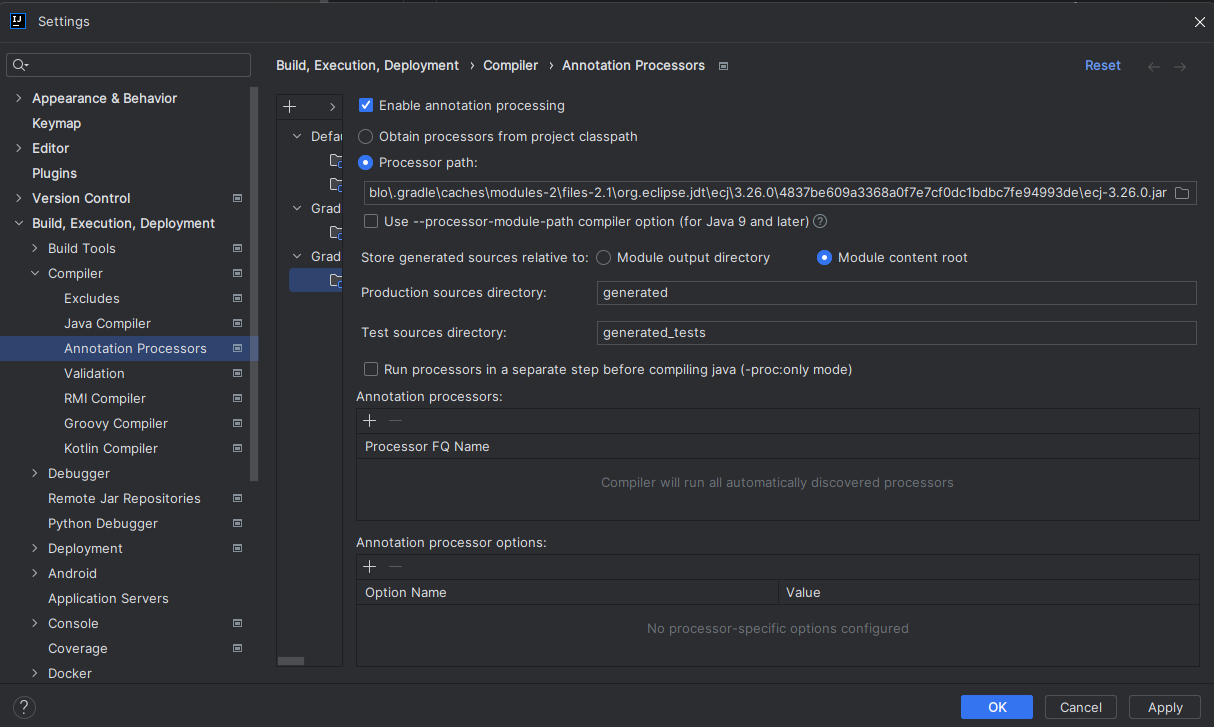

이런 경우 아래 사항들을 확인해보시기 바랍니다.- IDE의 Annotation 설정 확인

annotationProcessor을 사용하는 경우, IDE에서 해당 옵션을 활성해 줘야 합니다.

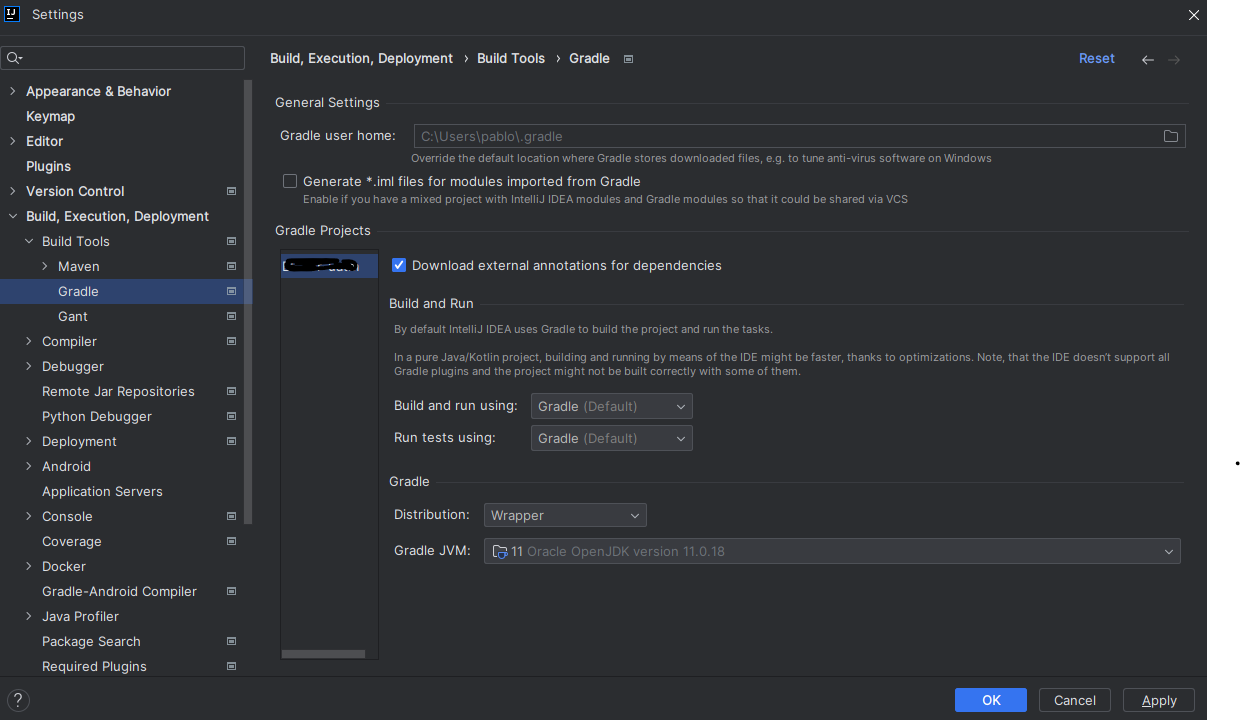

- IDE의 빌드 설정 확인

Gradle의 빌가 아닌 IDE의 빌드 사용.

QClass 생성 실패

test.java : error: cannot find symbol import test.QTest; ^QClass가 생성되어야 위 코드가 정상적으로 수행될텐데, 위 QTest라는 클래스가 없다며 빌드가 안되는 현상이 발생했습니다.

이러한 현상은 Class 또는 Interfaced를 정의 할 때, 상속 받는 Class나 추상 클래스의 구조가 다른 경우입니다.

( error: interface expected / Wrong number of type arguments)

- IDE의 Annotation 설정 확인

annotationProcessor을 사용하는 경우, IDE에서 해당 옵션을 활성해 줘야 합니다.

-

Airflow connections 추가하기

airflow

Airflow™ is a platform created by the community to programmatically author, schedule and monitor workflows.

데이터 파이프라인을 위한 오픈 소스 워크플로우 관리 플랫폼입니다.Python으로 작성된 DAG를 워크플로우 형태로 실행 할 수 있습니다.

pip으로 간단하게 설치하고, 관리를 위한 WEB을 제공합니다.

[설치 방법]Connections

Airflow의 Connection는 외부 서비스에 연결하는데 필요한 자격 증명 및 기타 정보를 저장하는데 사용됩니다.

연결 정보는 아래의 방법으로 정의 할 수 있습니다.- Environment variables

- Secrets Backend

- Airflow metadata database

Environment variables

JSON 또는 URI 형식의 환경 변수로 정의합니다. [상세]

JSON 형식

export AIRFLOW_CONN_MY_PROD_DATABASE='{ "conn_type": "my-conn-type", "login": "my-login", "password": "my-password", "host": "my-host", "port": 1234, "schema": "my-schema", "extra": { "param1": "val1", "param2": "val2" } }'URI 형식

export AIRFLOW_CONN_MY_PROD_DATABASE='my-conn-type://login:password@host:port/schema?param1=val1¶m2=val2'

Secrets Backend

Airflow와 연동되는 서비스의 공급자를 통해 연결 정보를 정의합니다. [상세]

지원하는 제공자는 다음과 같습니다.

Amazon

- SecretsManagerBackend

- SystemsManagerParameterStoreBackend

Google

- CloudSecretManagerBackend

Hashicorp

- VaultBackend

Microsoft Azure

- AzureKeyVaultBackend

Airflow metadata database

데이터베이스에 연걸 정보를 저장합니다.

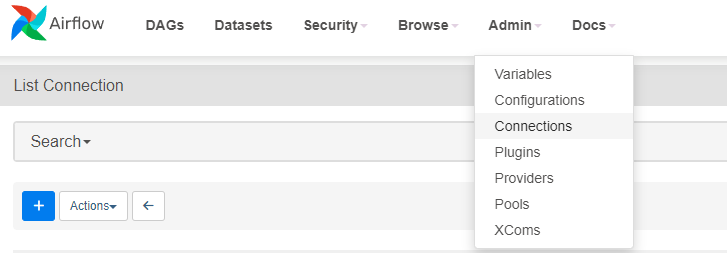

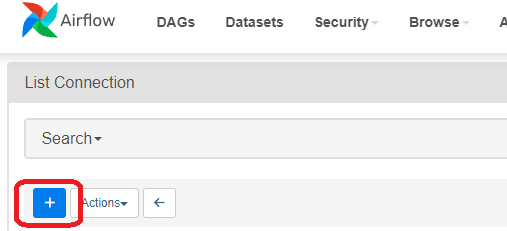

UI로 연결 만들기

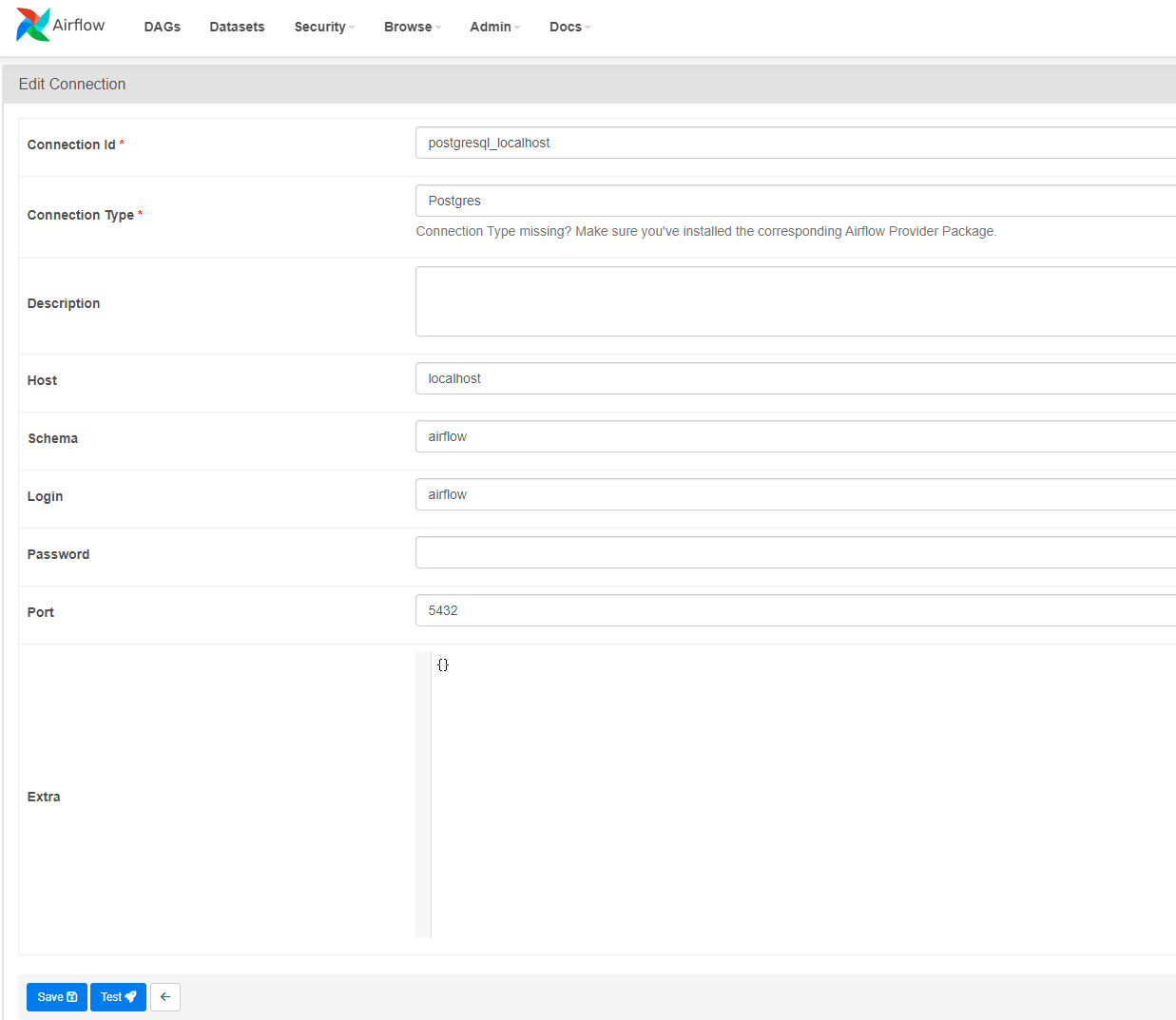

- Admin->Connections를 클릭하여 연결 관리 화면으로 이동합니다.

- [Add a New recode] 버튼을 클릭하여 새연결 생성하기 화면으로 이동합니다.

- 연결 정보를 입력하고 [Save] 버튼을 클릭합니다.

Connection Type missing? Make sure you’ve installed the corresponding Airflow Provider Package.

필요 시 Airflow Provider를 추가합니다.

Providers packages referenceCLI로 연결 추가하기

CLI에서 JSON형식으로 연결을 추가 할 수 있습니다.

airflow connections add 'my_prod_db' \ --conn-json '{ "conn_type": "my-conn-type", "login": "my-login", "password": "my-password", "host": "my-host", "port": 1234, "schema": "my-schema", "extra": { "param1": "val1", "param2": "val2" } }'